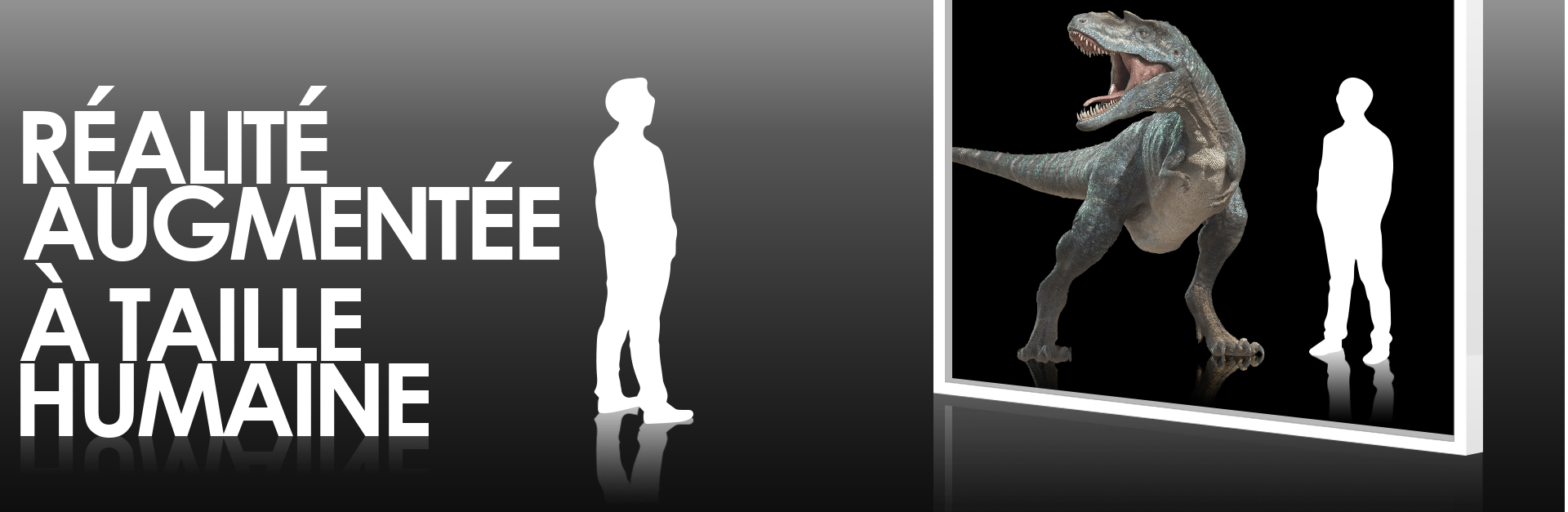

La réalité augmentée à taille humaine

Difficile de placer plusieurs personnes devant un smartphone ou une tablette.

Mais pour un événement indoor ou pour la scénographie d’une exposition, on peut passer à la dimension supérieure, et proposer une animation ludique et fascinante de réalité augmentée … à taille humaine.

Ce que j’entends par « taille humaine » ?

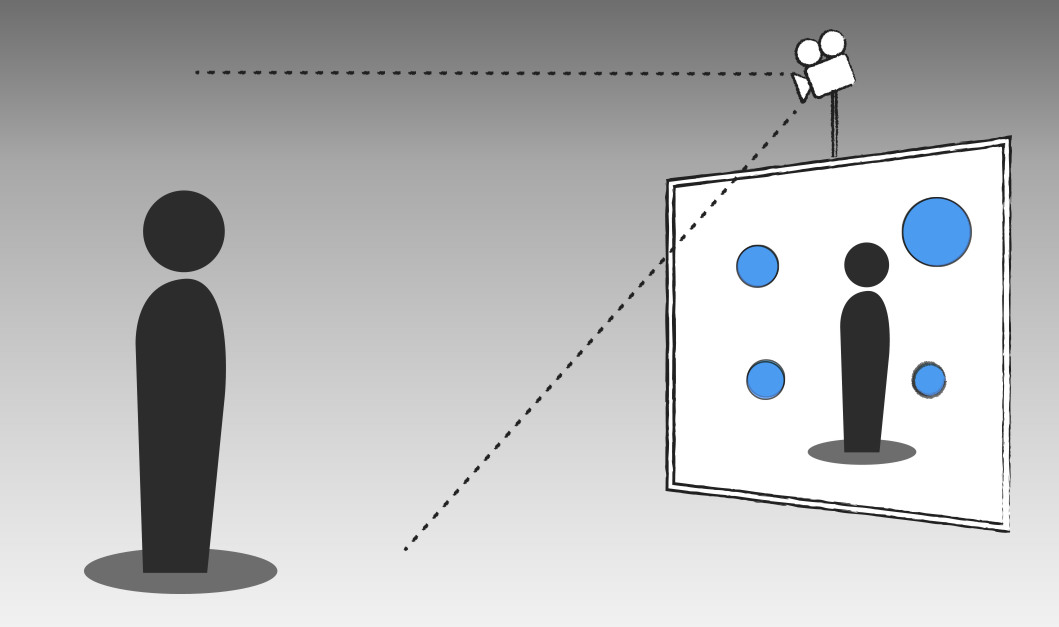

C’est lorsque le spectateur est filmé de plein pied, et qu’on intègre par vidéo-projection d’autres acteurs et éléments … virtuels. Comme exemple, voici les réalisations d’une agence londonienne – AppShake INDI – pour National Geographics :

L’expérience utilisateur

Alors que le spectateur se balade dans une galerie commerciale ou une exposition, il se découvre sur un écran géant. On l’invite à se positionner par un marquage au sol à un endroit précis. Ce marquage peut être un simple encart textuel ou un élément de décor réel de notre univers virtuel. Oui je sais, ce n’est pas simple, on ne sait plus trop ce qui est réel ou virtuel. Mais c’est de ça que naît la magie de la réalité augmentée. On détecte alors sa présence dans cette zone, et on déclenche une séquence animée virtuelle par dessus.

Le virtuel est diffusé sur l’écran, par-dessus la retransmission caméra et donc par-dessus les spectateurs. Ainsi, on ajoute des personnages imaginaires par-dessus les spectateurs, ou de terribles dinosaures qui frôlent le public, bref tout ce que l’on veut en fait. Le public joue de cette présence, cherche à interagir indirectement, et en un mot : s’amuse.

Le principe général de la réalité augmentée à taille humaine

On doit réaliser dans un premier temps une série de séquences en image de synthèse pré-calculées, de 30 à 45 secondes qui seront jouées de manière aléatoire ou scénarisée avec une progression narrative.

Ce point de vue permet au public de s’observer de face, comme dans un miroir géant. En levant la tête vers l’écran, il lève la tête vers la caméra. Ce positionnement est important, car les spectateurs ont toujours une tendance naturelle à chercher la caméra, il est donc intéressant que le parcours du regard écran-caméra soit le plus court possible.

Cette même mise en scène doit être imaginée en adéquation avec le contexte. Les personnages ou animaux doivent venir par les côtés, ou à la rigueur par le devant de la scène, en face des spectateurs. Ils ne peuvent pas, par contre, arriver par derrière, au risque de passer au travers des spectateurs sur leurs trajectoires, ce qui visuellement risque de casser le côté immersif — sauf si l’on souhaite jouer avec cet effet et mettre en scène un univers fantomatique.

En revanche, nous avons de la liberté dans cet espace (au premier plan) pour habiller la mise en scène. Nous pouvons matérialiser le sol avec une surface de terre ou enneigée ou une surface d’eau. L’univers virtuel en devient plus riche et on peut en profiter pour que le jeu des acteurs virtuels soit plus complet en interagissant avec le décor.

L’installation matérielle

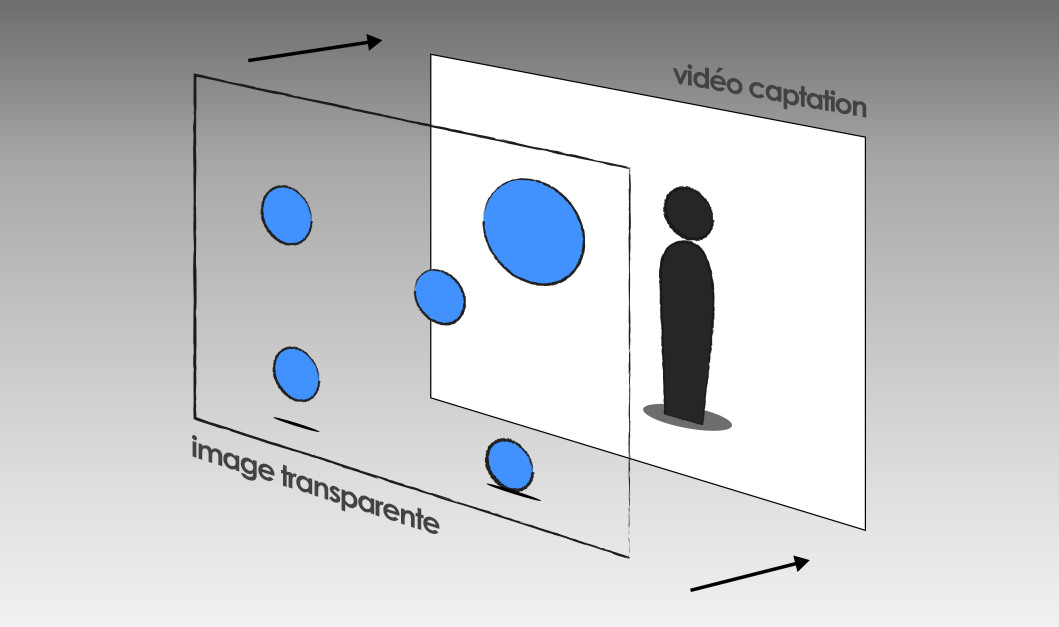

Pour mettre en œuvre cette animation, nous distinguons plusieurs composants distincts, qui sont la captation vidéo, son traitement et sa diffusion.

La captation :

Pour la captation vidéo, la caméra doit répondre à certaines contraintes liées à ce genre d’événement. Les caméras professionnelles, traditionnellement utilisées pour le tournage, ne supportent pas une longue durée d’utilisation de 8 à 12 h par jour. Elles surchauffent et les capteurs CCD peuvent (vont) en pâtir. On peut s’orienter vers un type de caméra particulier, initialement développé par les constructeurs pour des tournages de longue durée, comme les émissions de télé-réalité. Leurs composants sont prévus pour tourner 24/24H et diffuser un flux broadcast HD. Elle dispose d’une tête rotative pilotable à distance, ce qui permet d’affiner le positionnement du point de vue après l’installation et la fixation de la caméra. Bien entendu, une fois le point de vue ajusté, il ne devra plus bouger pendant toute la durée de l’événement. La qualité de la juxtaposition entre le point de vue réel et le point de vue virtuel est important pour une intégration cohérente et esthétique.

Le traitement :

La station graphique

Pour l’intégration, la composition et la diffusion d’un flux broadcast HD, il est nécessaire de prévoir une station graphique (PC) assez robuste pour réaliser l’ensemble de ces traitements relativement lourds lorsqu’on travaille sur du Live. En fonction du contexte du déploiement — lieu, structure du stand, durée d’utilisation, etc. — une bonne aération est à prévoir pour le refroidissement de la station, car elle va bien travailler. De même, l’informatique est sensible à l’empoussiérèrent qui étouffe les composants et amplifie la surchauffe électronique. Mais cela est vrai pour tout matériel dans un contexte hors bureau et domicile.

La station est composée :

- D’une carte pour la capture du flux vidéo broadcast provenant de la caméra. Il faut sélectionner du matériel « ouvert », offrant un SDK (un kit de développement) pour pouvoir interagir directement sur le flux vidéo sans passer par un logiciel propriétaire.

- Pour garantir une diffusion et une composition de qualité, il est préférable de générer des séquences non compressées et avec une information de transparence. Elles sont donc relativement lourdes en comparaison à un fichier vidéo numérique traditionnel. Pour remédier à cela, il faut prendre des disques durs avec suffisamment de capacité pour contenir l’ensemble de ces séquences imaginées, et rapides en lecture afin de pouvoir les lire en temps réel.

- Un dernier composant essentiel est la carte graphique. Elle est responsable de la diffusion du flux final vers l’écran, mais elle est exploitée aussi pour la détection des spectateurs et la composition live des différents flux vidéos. En effet, au-delà du processeur traditionnel, on utilise les processeurs de la carte graphique, qui sont par définition, bien adaptés au traitement des images.

L’application de compositing live

L’application de compositing live est la pierre angulaire de l’animation de réalité augmentée à taille humaine.

Elle a de nombreuses responsabilités :

- capturer le flux vidéo broadcast provenant de la caméra qui filme le public ;

- détecter la présence ou non d’un ou plusieurs spectateurs dans la zone de marquage ;

- précharger la séquence d’animation désirée — le choix de la séquence est effectué en fonction d’un scénario préétabli ;

- composer le flux vidéo en incrustant la bonne séquence virtuelle sur la captation vidéo ;

- diffuser le résultat à l’écran.

Comme vous l’aurez remarqué, j’utilise le terme de live et non temps réel, car il subsiste quelques millisecondes de décalage entre la captation et la diffusion. Elle est due aux différents traitements de détection et de composition réalisé par la station graphique. Néanmoins, ce retard est faible et ne sera perceptible que par les personnes les plus averties et attentives à ce phénomène.

La diffusion

La diffusion doit être large pour être vue avec du recul par un maximum de personnes. On peut exploiter un écran géant LED exploitable pour de la diffusion plein-jour, ou alors un mur d’écrans composés de 6 ou 9 écrans bien jointés. Le système de diffusion doit être en mesure de diffuser un flux vidéo broadcast HD.

Le point le plus délicat de l’installation pour effet bluffant, est d’avoir le même positionnement de la caméra réelle et virtuelle. On doit pouvoir connaître en amont de l’installation la position exacte de la caméra. Des tests sur la structure préalablement montée sont donc nécessaires pour affiner le calibrage, avant de générer la version finale des séquences. Il faut un minimum d’anticipation avant l’installation définitive, surtout si votre animation marque un événement à une date précise.

La mise en oeuvre artistique

Sur cette base de configuration matérielle et logicielle, on peut laisser libre cours à son imagination pour plonger les spectateurs dans un nouveau monde. Voici quelques pistes, mais je suis sûr que vous avez déjà quelques idées.

Choisir son univers

Il est possible de mettre en scène de nombreux univers dans cette animation. Ils peuvent être basés sur des personnages et des décors imaginaires ou réalistes.

On peut créer des personnages ludiques évoluant au milieu du public. Ils jouent entre eux, viennent saluer les spectateurs, font des cabrioles. Cette approche permet de s’adapter au contexte d’une animation, pour un événement donné.

Ainsi, on peut imaginer développer un thème “Halloween”, un thème de fêtes de fin d’année, ou autour d’un autre événement marketing – non, je ne sous-entend pas que Halloween est un événement marketing,….

On peut aussi jouer la carte de l’extraordinaire : Une rencontre avec des dinosaures ! D’abord, les dinosaures, c’est cool ! Ils fascinent autant les plus jeunes que les grands. Et en plus, leur succès permet de profiter de modèles 3D de qualité issus de bibliothèques existantes, ce qui fait du bien au budget.

Pensez à scénariser

Scénario est peut-être un grand mot, nous parlerons plus de progression dans l’animation. Il est intéressant de réaliser une série de séquences, qui se déclencheront dans un ordre précis, proposant une progression et un intérêt grandissant dans l’interaction et l’immersion du spectateur. Ceci permet de conserver la curiosité de la personne qui a pris le temps de s’arrêter et par effet boule de neige, d’ attiser la curiosité des autres passants.

Mettre en scène des séquences en réalité augmentée

La mise en scène concerne essentiellement l’animation des personnages ou des grosses bébêtes. On a moins de marge pour faire évoluer le décor qui doit garder une certaine rigidité, mais on peut tout de même jouer avec des éléments climatiques (la neige, l’orage, le vent,…) ou modifier la surface du sol (effondrement, vagues, lave,…).

Les personnages s’adaptent bien à de la captures de mouvement, pour leur donner vie rapidement.

Le jeu de l’acteur doit tenir compte de la mise en scène réelle et virtuelle. Mais le plus intéressant reste encore de jouer avec le positionnement potentiel des spectateurs, pour les interpeller et interagir avec eux. Des séquences de 30 à 45 secondes permettent un bon roulement des spectateurs sur le marquage.

Et l’arrivée de nouvelles personnes déclenche la séquence suivante, et la suite de l’histoire.

La génération des séquences

Une fois que tout est en place, on finit par générer/calculer les séquences pour alimenter l’application interactive. Cette génération se fait en fonction du point de vue de la caméra. Et si pour une raison ou une autre, la configuration physique de l’animation vient à évoluer, lors d’un déménagement de l’animation par exemple, il est toujours possible de régénérer rapidement les séquences pour s’adapter au nouveau contexte.

Et la réalité prend une nouvelle dimension.

Voilà, tout est prêt pour plonger le spectateur dans un univers virtuel où beaucoup de choses peuvent se passer. Les limites ne sont que celles de l’imagination. De l’interaction à la contemplation, de la surprise à l’étonnement, la réalité augmentée à taille humaine permet de voir les choses en grand, d’ajouter une dimension supplémentaire a votre événement.

Retrouvez nos autres articles sur le sujet :